在網(wǎng)上看到python做圖像識(shí)別的相關(guān)文章后,真心感覺(jué)python的功能實(shí)在太強(qiáng)大,,因此將這些文章總結(jié)一下,,建立一下自己的知識(shí)體系,。

當(dāng)然了,,圖像識(shí)別這個(gè)話題作為計(jì)算機(jī)科學(xué)的一個(gè)分支,,不可能就在本文簡(jiǎn)單幾句就說(shuō)清,,所以本文只作基本算法的科普向,。

看到一篇博客是介紹這個(gè),,但他用的是PIL中的Image實(shí)現(xiàn)的,感覺(jué)比較麻煩,于是利用Opencv庫(kù)進(jìn)行了更簡(jiǎn)潔化的實(shí)現(xiàn),。

相關(guān)背景

要識(shí)別兩張相似圖像,,我們從感性上來(lái)談是怎么樣的一個(gè)過(guò)程?首先我們會(huì)區(qū)分這兩張相片的類型,,例如是風(fēng)景照,,還是人物照。風(fēng)景照中,,是沙漠還是海洋,,人物照中,兩個(gè)人是不是都是國(guó)字臉,,還是瓜子臉(還是倒瓜子臉……哈哈……),。

那么從機(jī)器的角度來(lái)說(shuō)也是這樣的,先識(shí)別圖像的特征,,然后再相比,。

很顯然,在沒(méi)有經(jīng)過(guò)訓(xùn)練的計(jì)算機(jī)(即建立模型),,那么計(jì)算機(jī)很難區(qū)分什么是海洋,,什么是沙漠。但是計(jì)算機(jī)很容易識(shí)別到圖像的像素值,。

因此,,在圖像識(shí)別中,,顏色特征是最為常用的,。(其余常用的特征還有紋理特征、形狀特征和空間關(guān)系特征等)

其中又分為

-

直方圖

-

顏色集

-

顏色矩

-

聚合向量

-

相關(guān)圖

直方圖計(jì)算法

這里先用直方圖進(jìn)行簡(jiǎn)單講述,。

先借用一下戀花蝶的圖片,,

從肉眼來(lái)看,這兩張圖片大概也有八成是相似的了,。

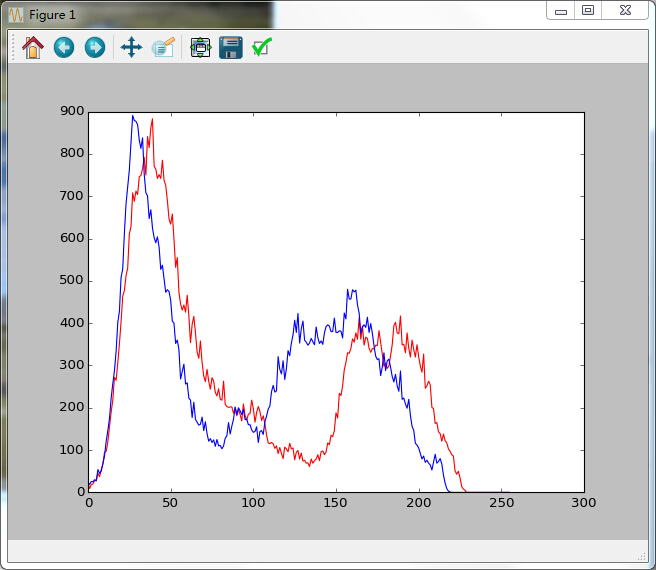

在python中利用opencv中的calcHist()方法獲取其直方圖數(shù)據(jù),,返回的結(jié)果是一個(gè)列表,使用matplotlib,,畫(huà)出了這兩張圖的直方圖數(shù)據(jù)圖

如下:

是的,,我們可以明顯的發(fā)現(xiàn),兩張圖片的直方圖還是比較重合的,。所以利用直方圖判斷兩張圖片的是否相似的方法就是,,計(jì)算其直方圖的重合程度即可。

計(jì)算方法如下:

其中g(shù)i和si是分別指兩條曲線的第i個(gè)點(diǎn),。

最后計(jì)算得出的結(jié)果就是就是其相似程度,。

不過(guò),這種方法有一個(gè)明顯的弱點(diǎn),,就是他是按照顏色的全局分布來(lái)看的,,無(wú)法描述顏色的局部分布和色彩所處的位置,。

也就是假如一張圖片以藍(lán)色為主,內(nèi)容是一片藍(lán)天,,而另外一張圖片也是藍(lán)色為主,,但是內(nèi)容卻是妹子穿了藍(lán)色裙子,那么這個(gè)算法也很可能認(rèn)為這兩張圖片的相似的,。

緩解這個(gè)弱點(diǎn)有一個(gè)方法就是利用Image的crop方法把圖片等分,,然后再分別計(jì)算其相似度,最后綜合考慮,。

圖像指紋與漢明距離

在介紹下面其他判別相似度的方法前,,先補(bǔ)充一些概念。第一個(gè)就是圖像指紋

圖像指紋和人的指紋一樣,,是身份的象征,,而圖像指紋簡(jiǎn)單點(diǎn)來(lái)講,就是將圖像按照一定的哈希算法,,經(jīng)過(guò)運(yùn)算后得出的一組二進(jìn)制數(shù)字,。

說(shuō)到這里,就可以順帶引出漢明距離的概念了,。

假如一組二進(jìn)制數(shù)據(jù)為101,,另外一組為111,那么顯然把第一組的第二位數(shù)據(jù)0改成1就可以變成第二組數(shù)據(jù)111,,所以兩組數(shù)據(jù)的漢明距離就為1

簡(jiǎn)單點(diǎn)說(shuō),,漢明距離就是一組二進(jìn)制數(shù)據(jù)變成另一組數(shù)據(jù)所需的步驟數(shù),顯然,,這個(gè)數(shù)值可以衡量?jī)蓮垐D片的差異,,漢明距離越小,則代表相似度越高,。漢明距離為0,,即代表兩張圖片完全一樣。

如何計(jì)算得到漢明距離,,請(qǐng)看下面三種哈希算法

平均哈希法(aHash)

此算法是基于比較灰度圖每個(gè)像素與平均值來(lái)實(shí)現(xiàn)的

一般步驟

-

1.縮放圖片,,一般大小為8*8,64個(gè)像素值,。

-

2.轉(zhuǎn)化為灰度圖

-

3.計(jì)算平均值:計(jì)算進(jìn)行灰度處理后圖片的所有像素點(diǎn)的平均值,,直接用numpy中的mean()計(jì)算即可。

-

4.比較像素灰度值:遍歷灰度圖片每一個(gè)像素,,如果大于平均值記錄為1,,否則為0.

-

5.得到信息指紋:組合64個(gè)bit位,順序隨意保持一致性。

最后比對(duì)兩張圖片的指紋,,獲得漢明距離即可,。

感知哈希算法(pHash)

平均哈希算法過(guò)于嚴(yán)格,不夠精確,,更適合搜索縮略圖,,為了獲得更精確的結(jié)果可以選擇感知哈希算法,它采用的是DCT(離散余弦變換)來(lái)降低頻率的方法

一般步驟:

-

縮小圖片:32 * 32是一個(gè)較好的大小,,這樣方便DCT計(jì)算

-

轉(zhuǎn)化為灰度圖

-

計(jì)算DCT:利用Opencv中提供的dct()方法,,注意輸入的圖像必須是32位浮點(diǎn)型,所以先利用numpy中的float32進(jìn)行轉(zhuǎn)換

-

縮小DCT:DCT計(jì)算后的矩陣是32 * 32,,保留左上角的8

* 8,,這些代表的圖片的最低頻率

-

計(jì)算平均值:計(jì)算縮小DCT后的所有像素點(diǎn)的平均值。

-

進(jìn)一步減小DCT:大于平均值記錄為1,,反之記錄為0.

-

得到信息指紋:組合64個(gè)信息位,,順序隨意保持一致性。

最后比對(duì)兩張圖片的指紋,,獲得漢明距離即可,。

dHash算法

相比pHash,dHash的速度要快的多,,相比aHash,,dHash在效率幾乎相同的情況下的效果要更好,它是基于漸變實(shí)現(xiàn)的,。

步驟:

-

縮小圖片:收縮到9*8的大小,,以便它有72的像素點(diǎn)

-

轉(zhuǎn)化為灰度圖

-

計(jì)算差異值:dHash算法工作在相鄰像素之間,這樣每行9個(gè)像素之間產(chǎn)生了8個(gè)不同的差異,,一共8行,,則產(chǎn)生了64個(gè)差異值

-

獲得指紋:如果左邊的像素比右邊的更亮,則記錄為1,,否則為0.

最后比對(duì)兩張圖片的指紋,獲得漢明距離即可,。

整個(gè)的代碼實(shí)現(xiàn)如下:

from matplotlib import pyplot as plt def classify_gray_hist(image1,image2,size = (256,256)): image1 = cv2.resize(image1,size) image2 = cv2.resize(image2,size) hist1 = cv2.calcHist([image1],[0],None,[256],[0.0,255.0]) hist2 = cv2.calcHist([image2],[0],None,[256],[0.0,255.0]) plt.plot(range(256),hist1,'r') plt.plot(range(256),hist2,'b') for i in range(len(hist1)): degree = degree (1 - abs(hist1[i]-hist2[i])/max(hist1[i],hist2[i])) degree = degree/len(hist1) def calculate(image1,image2): hist1 = cv2.calcHist([image1],[0],None,[256],[0.0,255.0]) hist2 = cv2.calcHist([image2],[0],None,[256],[0.0,255.0]) for i in range(len(hist1)): degree = degree (1 - abs(hist1[i]-hist2[i])/max(hist1[i],hist2[i])) degree = degree/len(hist1) def classify_hist_with_split(image1,image2,size = (256,256)): image1 = cv2.resize(image1,size) image2 = cv2.resize(image2,size) sub_image1 = cv2.split(image1) sub_image2 = cv2.split(image2) for im1,im2 in zip(sub_image1,sub_image2): sub_data = calculate(im1,im2) def classify_aHash(image1,image2): image1 = cv2.resize(image1,(8,8)) image2 = cv2.resize(image2,(8,8)) gray1 = cv2.cvtColor(image1,cv2.COLOR_BGR2GRAY) gray2 = cv2.cvtColor(image2,cv2.COLOR_BGR2GRAY) return Hamming_distance(hash1,hash2) def classify_pHash(image1,image2): image1 = cv2.resize(image1,(32,32)) image2 = cv2.resize(image2,(32,32)) gray1 = cv2.cvtColor(image1,cv2.COLOR_BGR2GRAY) gray2 = cv2.cvtColor(image2,cv2.COLOR_BGR2GRAY) dct1 = cv2.dct(np.float32(gray1)) dct2 = cv2.dct(np.float32(gray2)) hash1 = getHash(dct1_roi) hash2 = getHash(dct2_roi) return Hamming_distance(hash1,hash2) for i in range(image.shape[0]): for j in range(image.shape[1]): def Hamming_distance(hash1,hash2): for index in range(len(hash1)): if hash1[index] != hash2[index]: if __name__ == '__main__': img1 = cv2.imread('10.jpg') img2 = cv2.imread('11.jpg') degree = classify_gray_hist(img1,img2)

|